"La matemática es una parte de la física. La física es una ciencia experimental, una parte de las ciencias naturales. La matemática es la parte de la física en la que los experimentos son baratos".

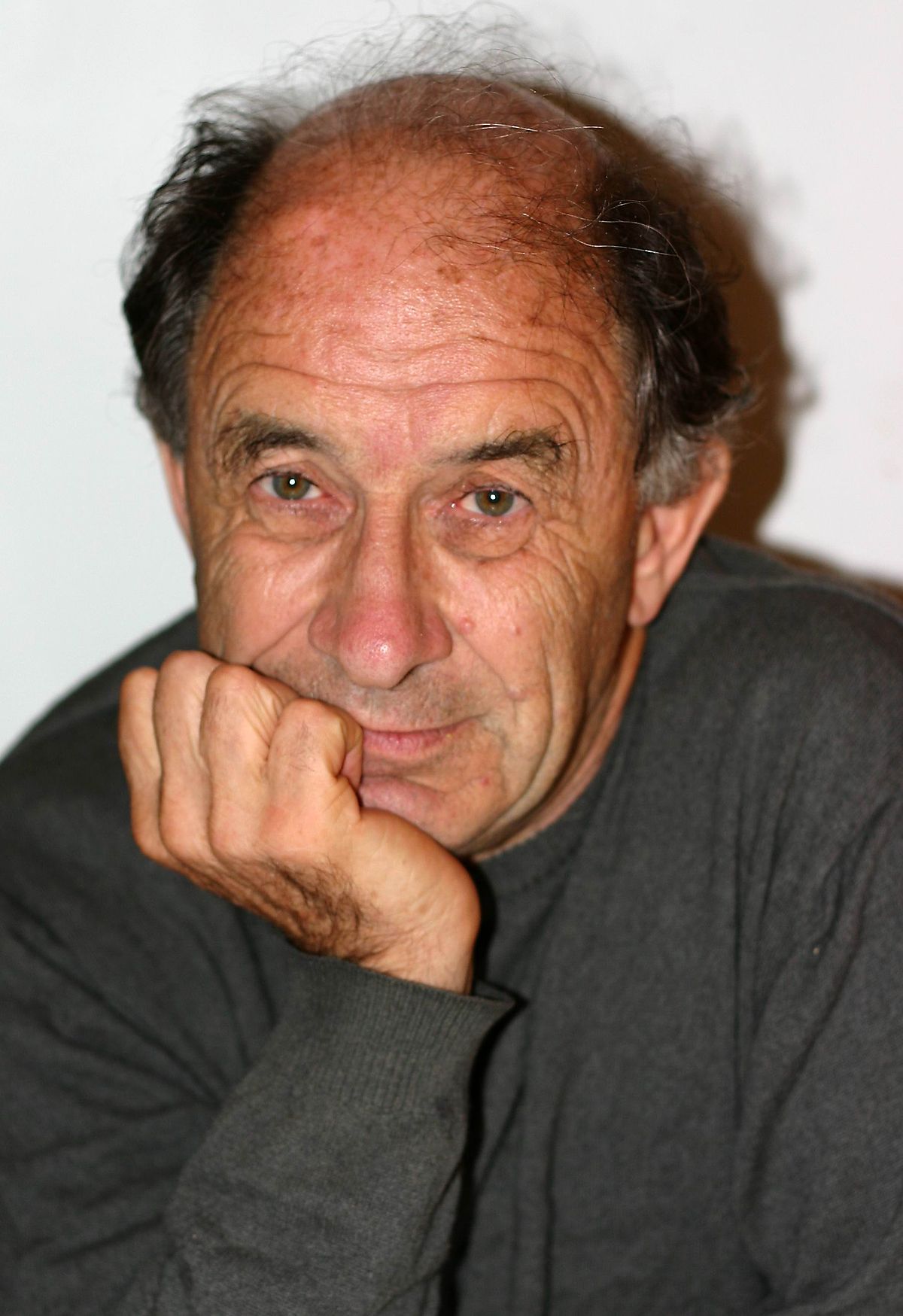

V.I. Arnold [Arnold1997]

Sí, ha leído usted bien. La matemática es justo lo contrario de lo que a muchos nos han contado en clase de matemáticas. Y el autor de estas afirmaciones no es cualquier charlatán que no sabe nada de matemáticas. Se trata de Vladímir Ígorevich Arnold, uno de los matemáticos más prolíficos de la historia, con contribuciones fundamentales a la teoría de los sistemas dinámicos, la teoría de las catástrofes, la topología, la geometría algebraica, la mecánica clásica y la teoría de la singularidad.

V.I. Arnold. De Светлана Третьякова - http://www.mccme.ru/arnold/pool/original/VI_Arnold-05.jpg, CC BY-SA 3.0, Enlace

El objetivo de este artículo es analizar en qué acertó Arnold y en qué se equivocó cuando pronunció estas frases. Para ello nos vamos a preguntar si es cierto lo que se nos dice normalmente en las clases de matemáticas de que la certeza que tenemos en los enunciados de las matemáticas es de una categoría superior a la de los enunciados de la física mejor establecida. También nos vamos a preguntar si los enunciados de las matemáticas son de distinta naturaleza que los de la física, como nos dicen normalmente en clase de filosofía. Spoiler: si eres cristiano, musulmán o judío, lo que viene a continuación puede que te vaya a gustar o puede que no. No lo sé. Este artículo no habla de tu religión. No te vas a encontrar en este texto ninguna afirmación que diga que tu dios no existe, ni ninguna burla a tus creencias. En cambio, si eres un matemático escolástico, posiblemente lo que vas a leer a continuación no te va a gustar. Estás a tiempo de cerrar esta pestaña.

¿Estamos seguros de que las verdades matemáticas son ciertas?

¿Estamos realmente en condiciones de afirmar que el enunciado de la conjetura de Goldbach es un enunciado verdadero?

¿Somos capaces de afirmar que lo que dice el teorema fundamental de la aritmética es verdadero?

Cualquier persona que haya sido adoctrinada por la secta de los matemáticos escolásticos no se va a atrever a contestar afirmativamente a la primera pregunta, pero sí a la segunda. Nos dirá que nadie ha sido capaz todavía de probar la conjetura de Goldbach y que no puede descartar que sea falsa, pero que sí tenemos una forma rigurosa de demostrar el teorema fundamental de la aritmética. Ese enunciado es un teorema de la aritmética que se puede probar a partir de los axiomas de Peano.

¿Somos capaces de afirmar que lo que dice el teorema fundamental de la aritmética es verdadero?

Pero hay un problema con esto. Aunque esa inferencia esté bien hecha y, por tanto, sea válida, eso no significa que tenga que ser una buena inferencia, ya que los axiomas de Peano podrían ser falsos, o incluso podrían ser inconsistentes. No sirve de nada "demostrar" algo a partir de unos axiomas inconsistentes, ya que de un conjunto de proposiciones inconsistentes entre ellas se puede deducir cualquier cosa. Podríamos probar la conjetura de Goldbach y, al mismo tiempo, su negación. Podríamos probar el teorema fundamental de la aritmética y, al mismo tiempo su negación. Para poder descartar con seguridad este escenario catastrófico para las matemáticas, es necesario, por tanto, demostrar que los axiomas de Peano son consistentes.

Afortunadamente, sí tenemos una demostración de que los axiomas de Peano son consistentes. El problema es que esa demostración parte de los axiomas de la teoría de conjuntos, axiomas más fuertes que los de Peano y, por tanto, más sospechosos de ser inconsistentes. Es decir, si la aritmética fuera inconsistente, también lo sería la teoría de conjuntos. Es como si ocurre un asesinato, y tenemos un testigo que tiene toda la pinta de ser de confianza, pero no estamos totalmente seguros de que está diciendo la verdad y, para estar seguros de que ese testigo es de fiar, preguntamos a otra persona que conoce a ese testigo si ese testigo es de fiar. Esa segunda persona nos dice que sí, que es de fiar, pero ese testimonio no nos termina de servir porque esa segunda persona parece menos de fiar que la primera.

Para estar totalmente seguros al 100% de que lo que dicen los teoremas de la aritmética es cierto, lo que necesitamos es una prueba de que la aritmética es consistente dentro de la misma aritmética. Desgraciadamente, esto es imposible. El segundo teorema de Gödel nos dice que cualquier sistema axiomático interesante sólo puede probar su propia consistencia si es en sí mismo inconsistente [Gödel1931].

Kurt Gödel. De Desconocido - Familienalbum der Familie Gödel, Scan from Gianbruno Guerrerio, Kurt Gödel - Logische Paradoxien und mathematische Wahrheit, S.24, Dominio público, Enlace

No le queda a usted, querido lector, más remedio que reconocer que no está usted seguro de si la aritmética es consistente o no y, por tanto, no está usted seguro de que el enunciado de un teorema bien establecido de las matemáticas sea verdadero. No tiene usted evidencia de que todos los números naturales se pueden descomponer de forma única en productos de números primos más allá del hecho de que usted piensa que esto es así, pensamiento que, como sugirió Descartes, podría haber sido introducido en su cabeza por un demonio maligno.

Pues no. Claro que estamos seguros de que cualquier número natural, por muy grande que sea, tiene una descomposición única en productos de primos. Y no me refiero sólo al contundente apoyo experimental que tiene el teorema (se cumple para todos los números naturales con los que hemos hecho la comprobación). Estamos seguros de que lo que dice el teorema es cierto porque es un teorema de la aritmética y estamos seguros de que la aritmética es consistente. Pero no porque podamos demostrarlo matemáticamente. El motivo por que el que no hay ningún matemático que piense que la aritmética es inconsistente es de la misma naturaleza que el motivo por el que los físicos de partículas están convencidos de que los electrones y los fotones interaccionan entre ellos de acuerdo a las leyes de la electrodinámica cuántica. Tenemos pruebas experimentales muy sólidas de que esto es así. Desde que éramos muy pequeños hemos sumado a 2 cosas 3 cosas, y hemos comprobado que el resultado es 5 cosas. Cientos de miles de matemáticos a lo largo de la historia han jugado con la aritmética probando teoremas dentro de ella e insertándola también en estructuras más ricas (y ahora también haciendo comprobaciones numéricas altamente no triviales con ordenadores) y lo que han encontrado es una estructura muy rica sin ningún tipo de señal de que haya alguna inconsistencia. Tener a matemáticos "convirtiendo café en teoremas" (sí, la mayoría de los científicos son unos yonquis, pero este problema no es exclusivo de los científicos) para ver si encuentran alguna contradicción en el sistema axiomático y para ver si estos teoremas tienen aplicaciones prácticas es en sí mismo un experimento científico. Probar teoremas a partir de axiomas y postulados es una actividad que se incluye dentro de la tarea de hacer experimentos, como hacen los demás científicos. En última instancia, la evidencia que tenemos de que los enunciados de la aritmética, y los del resto de las matemáticas, son verdaderos es experimental. La aritmética, como el resto de las matemáticas, es una teoría perteneciente al campo de la ciencia experimental, probablemente la más sólida y que más tests experimentales ha pasado de todas las teorías que tenemos.

Merece la pena leer lo que el lógico e historiador de la ciencia P. H. Nidditch escribió acerca de la crisis fundacional de la matemática que tuvo lugar a principios del siglo XX, tras los descubrimientos de antinomias como la de Russell o la de Burali-Forti:

"El temor a que los actuales sistemas de la matemática pudieran ser inconsistentes ha sido el principal responsable de que se produzca un cambio en la dirección de la Lógica Matemática hacia la metamatemática, con lo objetivo de liberarse de la penosa duda de si las matemáticas están o no descansando sobre una base sólida. Una razón especial para preocuparse al respecto es que la teoría de conjuntos es utilizada en todas las partes de las matemáticas; por tanto, si la teoría de conjuntos está mal de alguna manera, todas las demás partes se verán conducidas a error. Más aún, dejando a un lado la teoría de conjuntos, ¿no podría ser que súbitamente se realizaran descubrimientos de teoremas contradictorios en álgebra, geometría o en análisis matemático, como ocurrió con los descubrimientos de Burali-Forti y Russell? Ya ha quedado demostrado que el sentido común no es un faro lo bastante poderoso como para mantenernos a salvo del riesgo de vernos zozobrar contra los escarpados salientes de la lógica. Para estar, con buena razón, seguros de que los sistemas matemáticos son todos correctos, es necesario examinar con cuidado los detalles de sus estructuras, y dar demostraciones de que, con esas estructuras, la consistencia está presente.

Esta última preocupación, junto con el temor y la obsesión de la que hemos hablado en estas líneas, han sido y son comunes entre los que investigan en lo que se denomina "los fundamentos de la matemática", esto es, sistemas axiomáticos de lógica-conjuntos-y-aritmética. Sin embargo, algunas personas, con las cuales concuerda quien escribe este libro, tienen una opinión diferente. Estas personas dirían que el bienestar de la matemática no depende de sus "fundamentos". El valor de la matemática está en los frutos de sus ramas más que en sus "raíces"; en el gran número de sorprendentes e interesantes teoremas de álgebra, análisis, geometría, topología, teoría de números y teoría de probabilidades, más que en los intentos de obtener un fragmento de la aritmética o la topología como un mero desarrollo de la lógica. Dirían que el nombre "fundamentos de la matemática" es un nombre desafortunado, en la medida en que transmite a la mente una imagen errónea de las relaciones entre la lógica y la matemática superior. La matemática superior no se fundamenta en la lógica ni está constituida por la lógica. Dirían que las perturbaciones en teoría de conjuntos eran debidas a los singularísimos ejemplos de conjuntos aducidos, y que semenjantes conjuntos no eran usados en la matemática superior. Y añadirían que, si bien es deseable tener certeza de la consistencia, supuesto que nos sea posible llegar a un conocimiento de esa índole, no obstante, un conocimiento de la teoría matemática que sea sólo probable es generalmente suficiente, y el único tipo de conocimiento de la consistencia que, de hecho, generalmente se tiene. Y alegarán que un tal conocimiento probable encuentra un buen soporte en el hecho de que se haya trabajado tanto en las teorías de la matemática y no hayan salido a la luz teoremas contradictorios" [Nidditch1962].

También es necesario aclarar que no es cierto que el trabajo de los matemáticos profesionales sea simplemente "convertir café en teoremas". Como afirma Terence Tao, al contrario que los estudiantes universitarios, los matemáticos profesionales "ya no necesitan el formalismo para realizar razonamientos matemáticos de alto nivel, y llevan a cabo su tarea en una gran parte mediante su intuición". Esto se debe a que "el objetivo del rigor matemático no es destruir toda intuición, sino destruir la mala intuición al mismo tiempo que se clarifica y se potencia la buena intuición" [Tao2009]. Nótese que "destruir la mala intuición al mismo tiempo que se clarifica y se potencia la buena intuición" no deja de ser un ejercicio similar a la actualización bayesiana de los grados de confianza que se lleva a cabo en la ciencias naturales.

Merece la pena leer lo que el lógico e historiador de la ciencia P. H. Nidditch escribió acerca de la crisis fundacional de la matemática que tuvo lugar a principios del siglo XX, tras los descubrimientos de antinomias como la de Russell o la de Burali-Forti:

"El temor a que los actuales sistemas de la matemática pudieran ser inconsistentes ha sido el principal responsable de que se produzca un cambio en la dirección de la Lógica Matemática hacia la metamatemática, con lo objetivo de liberarse de la penosa duda de si las matemáticas están o no descansando sobre una base sólida. Una razón especial para preocuparse al respecto es que la teoría de conjuntos es utilizada en todas las partes de las matemáticas; por tanto, si la teoría de conjuntos está mal de alguna manera, todas las demás partes se verán conducidas a error. Más aún, dejando a un lado la teoría de conjuntos, ¿no podría ser que súbitamente se realizaran descubrimientos de teoremas contradictorios en álgebra, geometría o en análisis matemático, como ocurrió con los descubrimientos de Burali-Forti y Russell? Ya ha quedado demostrado que el sentido común no es un faro lo bastante poderoso como para mantenernos a salvo del riesgo de vernos zozobrar contra los escarpados salientes de la lógica. Para estar, con buena razón, seguros de que los sistemas matemáticos son todos correctos, es necesario examinar con cuidado los detalles de sus estructuras, y dar demostraciones de que, con esas estructuras, la consistencia está presente.

Esta última preocupación, junto con el temor y la obsesión de la que hemos hablado en estas líneas, han sido y son comunes entre los que investigan en lo que se denomina "los fundamentos de la matemática", esto es, sistemas axiomáticos de lógica-conjuntos-y-aritmética. Sin embargo, algunas personas, con las cuales concuerda quien escribe este libro, tienen una opinión diferente. Estas personas dirían que el bienestar de la matemática no depende de sus "fundamentos". El valor de la matemática está en los frutos de sus ramas más que en sus "raíces"; en el gran número de sorprendentes e interesantes teoremas de álgebra, análisis, geometría, topología, teoría de números y teoría de probabilidades, más que en los intentos de obtener un fragmento de la aritmética o la topología como un mero desarrollo de la lógica. Dirían que el nombre "fundamentos de la matemática" es un nombre desafortunado, en la medida en que transmite a la mente una imagen errónea de las relaciones entre la lógica y la matemática superior. La matemática superior no se fundamenta en la lógica ni está constituida por la lógica. Dirían que las perturbaciones en teoría de conjuntos eran debidas a los singularísimos ejemplos de conjuntos aducidos, y que semenjantes conjuntos no eran usados en la matemática superior. Y añadirían que, si bien es deseable tener certeza de la consistencia, supuesto que nos sea posible llegar a un conocimiento de esa índole, no obstante, un conocimiento de la teoría matemática que sea sólo probable es generalmente suficiente, y el único tipo de conocimiento de la consistencia que, de hecho, generalmente se tiene. Y alegarán que un tal conocimiento probable encuentra un buen soporte en el hecho de que se haya trabajado tanto en las teorías de la matemática y no hayan salido a la luz teoremas contradictorios" [Nidditch1962].

También es necesario aclarar que no es cierto que el trabajo de los matemáticos profesionales sea simplemente "convertir café en teoremas". Como afirma Terence Tao, al contrario que los estudiantes universitarios, los matemáticos profesionales "ya no necesitan el formalismo para realizar razonamientos matemáticos de alto nivel, y llevan a cabo su tarea en una gran parte mediante su intuición". Esto se debe a que "el objetivo del rigor matemático no es destruir toda intuición, sino destruir la mala intuición al mismo tiempo que se clarifica y se potencia la buena intuición" [Tao2009]. Nótese que "destruir la mala intuición al mismo tiempo que se clarifica y se potencia la buena intuición" no deja de ser un ejercicio similar a la actualización bayesiana de los grados de confianza que se lleva a cabo en la ciencias naturales.

En realidad, la situación epistemológica en la que se encuentran las matemáticas es similar a la del resto de las ciencias naturales. La metodología que se utiliza en matemáticas no es más rigurosa que la del resto de ciencias por una cuestión de naturaleza, sino de grado. ¿Cuál es en realidad esta metodología? La explicación que da Arnold es la siguiente:

"El esquema de construcción de una teoría matemática es exactamente el mismo que el de cualquier otra de las ciencias naturales. Primero prestamos atención a objetos y hacemos observaciones en casos especiales. Luego probamos y encontramos los límites de aplicación de nuestras observaciones, buscamos contraejemplos que nos prevengan de extender injustificadamente nuestras observaciones hacia un rango demasiado extenso de eventos (por ejemplo, el número de particiones de números impares consecutivos 1, 3, 5, 7, 9 en un número impar de sumandos nos da la secuencia 1, 2, 4, 8, 16, pero a continuación aparece el 29).

Como resultado, formulamos el descubrimiento empírico que acabamos de hacer (por ejemplo, la conjetura de Fermat o la conjetura de Poincaré) de forma tan clara como sea posible. Después de esto, es cuando viene la difícil fase de comprobar cómo de fiable son nuestras conclusiones.

Para este punto, una técnica especial ha sido desarrollada en matemáticas. Esta técnica, cuando se aplica al mundo real, es algunas veces útil, pero puede a veces también conducir al autoengaño. A esta técnica se la denomina modelización. Al construir un modelo, hay que hacer la siguiente idealización: ciertos hechos que son sólo conocidos con un cierto grado de probabilidad o con un cierto grado de exactitud son considerados como "absolutamente" correctos y son aceptados como "axiomas". El sentido de esta "absolutez" descansa precisamente en el hecho de que nos damos permiso a nosotros mismos para utilizar estos "hechos" de acuerdo con las reglas de la lógica formal, en un proceso en el que asignamos la categoría de "teorema" a todo lo que de ellos se puede deducir.

Es obvio que en cualquier actividad de la vida real es imposible confiar completamente en tales deducciones. El motivo es que, por lo menos, los parámetros que caracterizan los fenómenos estudiados nunca son conocidos completamente de forma exacta y un pequeño cambio en los parámetros (por ejemplo, en las condiciones iniciales de un proceso) puede cambiar el resultado totalmente. Por ejemplo, este es el motivo por el que una predicción del tiempo meteorológico fiable a largo plazo es imposible y seguirá siendo imposible por mucho que mejoremos los ordenadores y los dispositivos que registran las condiciones iniciales. De la misma manera, un pequeño cambio en los axiomas (de los cuales no podemos estar por completo seguros) es capaz, en general, de conducir a conclusiones completamente distintas a aquellas que se obtienen a partir de los teoremas que se han podido deducir partiendo de los axiomas aceptados. Cuanto más larga y sofisticada sea la cadena de deducciones ("demostraciones"), menos fiable es el resultado final. Los modelos complejos pocas veces son útiles (salvo para aquellos que escriben sus tesis).

La técnica matemática de la modelización consiste en ignorar este problema y hablar sobre tu modelo deductivo como si coincidiese con la realidad. Al hecho de que este camino, que es obviamente incorrecto desde el punto de vista de las demás ciencias naturales, frecuentemente conduce a resultados útiles en física, se le denomina "la inconcebible efectividad de las matemáticas en las ciencias naturales" (o el "principio de Wigner").

[...]

"El sutil veneno de la formación en matemáticas" (en palabras de Klein) para un físico consiste precisamente en el hecho de que el modelo, considerado como "absoluto", se separa de la realidad y ya no se puede comparar con ella. Aquí puede verse un ejemplo simple: los matemáticos nos enseñan que la solución a la ecuación de Maltus $$

\frac{dx}{dt}=x

$$ queda completamente determinada por las condiciones iniciales (lo que es equivalente a decir que las correspondientes curvas integrales en el plano (t,x) no intersecan entre ellas). Pero esta conclusión del modelo matemático tiene poca relevancia en lo que respecta a la realidad. Los experimentos con ordenadores nos demuestran que todas estas curvas integrales tienen puntos en común en el semieje negativo temporal. En efecto, las curvas con, por ejemplo, las condiciones iniciales $x(0)=0$ y $x(0)=1$ prácticamente intersecan en $t=-10$, y en $t=-100$ ni siquiera cabe un átomo entre ellas. Las propiedades del espacio a esas distancias tan pequeñas ya no se pueden describir mediante la geometría euclídea. La aplicación del teorema de unicidad en esta situación obviamente está fuera del rango de validez del modelo. Esto se tiene que respetar en las aplicaciones prácticas del modelo ya que, si no, nos podemos encontrar con problemas serios.

Me gustaría remarcar que, sin embargo, este mismo teorema de unicidad explica por qué hay que hacer manualmente la fase de acercamiento en el proceso de amarre de un barco: en la conducción, si la velocidad de acercamiento hubiese sido definida como una función lineal suave de la distancia, el proceso de amarre habría requerido un periodo infinito de tiempo. [...] Este problema tuvo que ser encarado de forma seria al aterrizar aparatos en la Luna y en Marte y en los acoplos de las estaciones espaciales - aquí el teorema de unicidad juega en nuestra contra.

Desafortunadamente, en los modernos libros de texto de matemáticas no es posible encontrar, ni ninguno de estos ejemplo, ni ninguna discusión acerca de los peligros de fechitizar los teoremas, ni siquiera en los mejores libros. De hecho, incluso tengo la impresión de que los matemáticos escolásticos (aquellos que saben poco de física) creen que la matemática axiomática es distinta de la modelización que se lleva a cabo habitualmente en las ciencias naturales. Ésta última siempre requiere un posterior control de las deducciones mediante experimentos, pero creen que la matemática axiomática no.

Incluso aunque nos olvidemos del carácter relativo de los axiomas iniciales, no se puede ignorar la inevitabilidad de que se produzcan errores lógicos en las inferencias largas [...] con computadoras [...] y matemáticos después de diez páginas de fórmulas [...]. La tecnología necesaria para combatir tales errores es precisamente el mismo control externo que llevan a cabo los experimentadores en cualquier ciencia experimental y se debería enseñar desde el principio a todos los estudiantes en las escuelas.

Los intentos de crear unas matemáticas deductivo-axiomáticas "puras" han conducido al abandono del esquema que se usa en física (observación, modelo, investigación del modelo, conclusiones y comprobaciones experimentales) y sus sustitución por el esquema: definición, teorema, demostración. Es imposible entender una definición si no ha sido bien motivada pero esto no les para los pies a los algebristas-axiomatizadores criminales."

Todas estas frases forman parte del discurso que dio Arnold en el Palais de Découverte en Paris en 1997, en el que denuncia el daño que causaron esos matemáticos escolásticos al ocultar a los jóvenes que los objetos matemáticos, además de tener un significado algebraico y geométrico, también tienen un significado físico, cuyo conocimiento da al matemático una intuición que le sirve de potente faro, y que la modelización en matemáticas también necesita de confirmación experimental.

¿Son los enunciados de las matemáticas de distinta naturaleza que los de la física?

Ya hemos visto que la metodología que se utiliza en matemáticas no es de distinta naturaleza que la de la física. Pero, ¿qué ocurre con sus enunciados? En toda la tradición filosófica occidental siempre se ha considerado que los enunciados de las matemáticas (analíticos) poseen una naturaleza distinta a los de la física (que son sintéticos). Por ejemplo, La distinción kantiana entre verdades analíticas y verdades sintéticas fue anticipada por la distinción de Hume entre relaciones de ideas y cuestiones de hecho, y por la distinción leibniziana entre verdades de razón y verdades de hecho. Leibniz decía de las verdades de razón que son verdaderas en todos los mundos posibles.

Sin embargo, en 1951 el filósofo y lógico matemático norteamericano W. V. O. Quine, en el que se considera el artículo más importante del siglo XX en filosofía de la ciencia, enterró definitivamente de la filosofía la distinción entre verdades analíticas (verdades lógico-matemáticas, independientes de los hechos) y verdades sintéticas (basadas en los hechos) [Quine1951].

W.V.O. Quine

By (Photo booth?)Stampit at English Wikipedia. [CC BY-SA 2.5-2.0-1.0, GFDL or CC-BY-SA-3.0], via Wikimedia Commons

En este artículo Quine demuestra que todos los argumentos posibles que se puede proponer para intentar demostrar que son analíticos los enunciados del tipo "Ningún número de jugadores en un equipo que sea número compuesto es un número primo" son en realidad circulares. Podríamos decir que el enunciado es analítico porque, usando "compuesto" como sinónimo de "no primo", somos capaces de convertirlo en una tautología (descartemos los equipos de 1 jugador, ya que el 1 no se considera ni primo ni compuesto). Pero Quine demuestra que el concepto de sinonimia está tan necesitado de explicación como el de analiticidad, ya que todos los intentos de caracterizar conceptualmente la sinonimia acaban dependiendo de sí mismos o del concepto analiticidad.

Por ejemplo, un diccionario que traduzca "compuesto" por "no primo" no puede resolver el problema, porque los diccionarios son informes que recogen las sinonimias conocidas y, por tanto, dependen de la noción previa de sinonimia.

También podríamos explicar la sinonimia en términos de "intercambiabilidad": "compuesto" puede cambiarse por "no primo" en todas los enunciados sin que por ello cambie el valor de verdad de cada enunciado. Pero Quine demuestra que no es posible hacer esto de forma general garantizando que el motivo por el que el enunciado no ha cambiado su valor de verdad es por su significado y no por casualidad. Por ejemplo, podemos cambiar en todas los enunciados "criatura con corazón" por "criatura con riñón", y no por ello cambiaría su valor de verdad, ya que es un hecho experimental que todas las criaturas con corazón también tienen riñón, pero, entonces, el significado de los enunciados cambiaría, y no podemos decir que "Toda criatura con riñón es una criatura con corazón" sea precisamente un enunciado analítico. Podríamos añadir el adverbio modal "Necesariamente", con lo que sí quedaría claro que "Necesariamente, ningún compuesto es primo" es analítico, mientras que "Necesariamente, toda criatura con riñón es criatura con corazón" no lo es porque, al añadir "Necesariamente" se vuelve falso. Pero la noción de necesidad descansa sobre la de analiticidad, con lo que el argumento sería circular.

Otra definición posible sería decir que un enunciado analítico es aquel que está en el caso extremo de que no es necesaria una verificación empírica del mismo, porque queda confirmado independientemente de lo que salga en los experimentos. Pero para eso hace falta aceptar la teoría de la verificación del significado que dice que sólo los enunciados que son empíricamente verificables tienen significado, es decir, habría que aceptar el postulado reduccionista del positivismo. Pero el reduccionismo presenta un problema tan intratable como el de la analiticidad, ya que para llevar a cabo la empresa reduccionista es necesario especificar cómo traducir los datos sensibles a los enunciados de nuestro discurso, como intentó sin éxito Carnap. Carnap fracasó en esta empresa porque no tuvo más remedio que introducir notación lógica, de teoría de conjuntos y de localización en el espacio-tiempo, volviendo de nuevo a la analiticidad que pretendíamos definir.

Ante el fracaso de los positivistas en dar caracterizaciones no circulares de analiticidad y reduccionismo, Quine concluye que ambas nociones no son más que dogmas metafísicos de fe. En vez del reduccionismo, Quine propone que es la totalidad del conocimiento científico lo que es verificable, y no cada enunciado individualmente, porque prácticamente todos los enunciados en ciencia están interconectados. Al contrario de lo que decía Popper, no son, por tanto, los enunciados los que son falsables, sino la totalidad del conocimiento científico como un todo. Ante una evidencia experimental en contra habrá varias posibilidades de modificar toda la red de teorías e hipótesis para adaptarla a ésta. Un enunciado que es falso en una de estas posibilidades puede ser verdadero en otra. Estas ideas constituyen la denominada tesis de Duhem-Quine.

Por supuesto, hay enunciados, los que antes llamábamos "analíticos", que son menos susceptibles que otros, los que antes llamábamos "sintéticos", de ser modificados ante un resultado experimental en contra, pero, como señala Quine, la diferencia entre los enunciados "analíticos" de las matemáticas y los "sintéticos" de la física no es de naturaleza sino de grado: los resultados experimentales nos dan las condiciones de frontera que tiene que satisfacer la red que constituye todo el conocimiento científico. Los juicios que llamamos "sintéticos" están más cerca de esa frontera, con lo que, cuando hay un cambio en la frontera, al ajustar la red para adaptarse a ese cambio es más probable que los acabemos tocando, pero no tiene sentido hablar del contenido empírico de un enunciado concreto. Como afirmó Arnold "La identidad de Jacobi (que fuerza a que las tres alturas de todo triángulo se crucen en un punto) es un hecho experimental de la misma naturaleza que el hecho de que la Tierra es redonda, pero que se puede descubrir con menos dinero y esfuerzo" [Arnold1997]. A su vez, las leyes de la lógica dan las relaciones entre los distintos enunciados, pero ellas mismas también son enunciados del sistema y, por tanto, tampoco puede decirse que sean puramente analíticas, que no dependan de la experiencia.

Alguno puede pensar que es imposible que los enunciados de la matemática sean de la misma naturaleza que la de las ciencias que habitualmente se llaman "experimentales", ya que los objetos con los que trabaja la matemática son objetos abstractos, que entran dentro de otra categoría. Sin embargo, ya hemos visto en un artículo anterior que los objetos matemáticos tienen un triple significado: algebraico, geométrico y físico, y que uno no puede abarcarlos completamente si se olvida de su significado físico. Desgraciadamente, ha habido una escuela de pensamiento dominante durante la segunda mitad del siglo XX entre los matemáticos que ha tenido consecuencias nefastas para la enseñanza de las matemáticas y para la investigación, que ha actuado bajo el perverso objetivo de ocultar a los jóvenes el significado físico de los objetos matemáticos. Se ha intentado forzar una separación entre matemáticas y física teórica aislando a ambas comunidades de investigadores bajo la falsa excusa de que estudian disciplinas de distinta naturaleza. La realidad es que no lo son. Los objetivos y metodologías de ambos grupos sólo difieren en grado, pero esta realidad queda oscurecida por el hecho de que ambos colectivos utilizan un lenguaje muy distinto para referirse a los mismos objetos.

Afortunadamente, es difícil mantener una mentira de tal magnitud durante mucho tiempo, y esta barrera construida artificialmente entre físicos teóricos y matemáticos, debido a la diferente formación y diferente lenguaje que utilizan, está empezando a caer. Como explico en ese articulo anterior, en las últimas décadas las nuevas ideas en teoría cuántica de campos y teoría de cuerdas están revolucionando por completo las matemáticas. Ejemplos exitosos de la aplicación de conceptos físicos para resolver problemas matemáticos y crear nuevas ramas de la matemática, como mirror symmetry, la teoría de nudos o el monstrous moonshine, están obligando a ambos colectivos a entenderse de nuevo, haciendo ver a los matemáticos que despreciar el significado físico de los objetos con los que trabajan conlleva una visión estrecha de su disciplina y terminando de destruir el complejo de inferioridad que se había inoculado a muchos físicos al hacerles creer la mentira de que la naturaleza de las matemáticas se encuentra en un estatus superior en "pureza" a la de la física.

Alguno puede pensar que es imposible que los enunciados de la matemática sean de la misma naturaleza que la de las ciencias que habitualmente se llaman "experimentales", ya que los objetos con los que trabaja la matemática son objetos abstractos, que entran dentro de otra categoría. Sin embargo, ya hemos visto en un artículo anterior que los objetos matemáticos tienen un triple significado: algebraico, geométrico y físico, y que uno no puede abarcarlos completamente si se olvida de su significado físico. Desgraciadamente, ha habido una escuela de pensamiento dominante durante la segunda mitad del siglo XX entre los matemáticos que ha tenido consecuencias nefastas para la enseñanza de las matemáticas y para la investigación, que ha actuado bajo el perverso objetivo de ocultar a los jóvenes el significado físico de los objetos matemáticos. Se ha intentado forzar una separación entre matemáticas y física teórica aislando a ambas comunidades de investigadores bajo la falsa excusa de que estudian disciplinas de distinta naturaleza. La realidad es que no lo son. Los objetivos y metodologías de ambos grupos sólo difieren en grado, pero esta realidad queda oscurecida por el hecho de que ambos colectivos utilizan un lenguaje muy distinto para referirse a los mismos objetos.

Afortunadamente, es difícil mantener una mentira de tal magnitud durante mucho tiempo, y esta barrera construida artificialmente entre físicos teóricos y matemáticos, debido a la diferente formación y diferente lenguaje que utilizan, está empezando a caer. Como explico en ese articulo anterior, en las últimas décadas las nuevas ideas en teoría cuántica de campos y teoría de cuerdas están revolucionando por completo las matemáticas. Ejemplos exitosos de la aplicación de conceptos físicos para resolver problemas matemáticos y crear nuevas ramas de la matemática, como mirror symmetry, la teoría de nudos o el monstrous moonshine, están obligando a ambos colectivos a entenderse de nuevo, haciendo ver a los matemáticos que despreciar el significado físico de los objetos con los que trabajan conlleva una visión estrecha de su disciplina y terminando de destruir el complejo de inferioridad que se había inoculado a muchos físicos al hacerles creer la mentira de que la naturaleza de las matemáticas se encuentra en un estatus superior en "pureza" a la de la física.

Conclusión

Ni la metodología que se usa en matemáticas ni los enunciados con los que ésta trabaja difieren en naturaleza con lo que se hace en física. Arnold tenía razón. La matemática es una ciencia experimental y, además, ni siquiera se puede establecer una frontera clara entre ésta y la física teórica.

Nos vemos, por tanto, obligados a sustituir esta popular viñeta en las redes sociales:

por esta otra:

donde en el grupo "dogmatism" podemos englobar a los matemáticos y lógicos escolásticos que creen que sus sistemas axiomáticos están a salvo de necesitar confirmación experimental. Los matemáticos y lógicos de verdad, como Arnold, Tao, Gödel, Quine, Nidditch, etc, formarían parte, junto con los físicos, de la parte más pura de los que practican el pensamiento racional. Y todo esto, por supuesto, sin menospreciar la importancia de las otras ciencias que, aunque fundamentadas en la que tienen a su derecha, tienen todo el derecho a poseer la categoría de ciencia por sus propias metodologías y por la complejidad y singularidad de sus metodologías y de los sistemas que estudian.

Eso sí, no podemos terminar este artículo sin señalar un error importante en la afirmación de Arnold con la que hemos comenzado este texto. Los experimentos en matemáticas no son baratos, y el motivo no es sólo que las supercomputadoras cuestan mucho dinero. Hay que pagar bien a los matemáticos y a los físicos teóricos para que desarrollen su trabajo en condiciones dignas, dedicando no más de 40 horas a la semana, con un sueldo adecuado y con una estabilidad laboral, tras leer la tesis, suficiente como para que nadie tenga que elegir entre asumir sus responsabilidades con sus hijos y con los ancianos de su familia o seguir con la carrera investigadora. Eso no se está haciendo, y la consecuencia es que se está expulsando masivamente de la academia a las mujeres en mitad de su carrera científica (y también a los hombres que sí asumen esas responsabilidades familiares), mientras se está dando una ventaja que no merecen a los hombres más irresponsables. Si acabáramos con esta situación de explotación y el trabajo de investigador en la etapa de postdoc fuera compatible con la vida, las matemáticas ya no serían tan baratas. Arnold no deja de ser un señoro del siglo pasado, capaz de ver algunas cosas con una profundidad alucinante, mientras no se daba cuenta de lo que sucedía delante de sus narices.

Sobre el autor: Sergio Montañez Naz es doctor en física y profesor de secundaria de la enseñanza pública en la Comunidad de Madrid.

Sobre el autor: Sergio Montañez Naz es doctor en física y profesor de secundaria de la enseñanza pública en la Comunidad de Madrid.

Referencias bibliográficas

- Arnold V.I. (1998) "On teaching mathematics". Uspekhi Mat. Nauk 53 (1998), no. 1, 229-234.

- Gödel, K. (1992) [1931] On Formally Undecidable Propositions of Principia Mathematica and Related Systems. New York: Dover, 1992

- Quine W.V.O. (1951) "Two dogmas of empirism", Philosophical Review 60: 20–43.

- Nidditch P.H. (1962). The development of mathematical logic. Monographs in modern logic. Routledge & Kegan Paul, London, and The Free Press of Glencoe, New York.

- Tao T. (2009). "There’s more to mathematics than rigour and proofs". What's new.

Hola, no entiendo una cosa. Si las matemáticas son experimentales, ¿cómo Gödel demuestra que su segundo teorema sin utilizar la experimentación? Gracias

ResponderEliminarGracias Leo por el interés en debatir sobre este asunto. Hasta ahora me he encontrado en las redes sociales varios tipos de personas, entre los que no hay nadie dispuesto a debatir:

Eliminar-Gente que ya veía evidente que la matemática es experimental porque no hay motivo para darle un estatus diferente a las demás ciencias.

-Gente que afirma que la matemática no es experimental, porque es así y punto y se niegan siquiera a leer este post.

-Gente que abre el post con el objetivo de ridiculizar mis argumentos, y que se encuentra con que los argumentos no son míos. Me he limitado a recoger los pensamientos de los verdaderos expertos en este tema. Pensamientos trabajados a tan alto nivel que quedan muy por encima de la respuesta pasional y rápida que pensaban darme. Al darse cuenta de esto colapsan, cierran los ojos, se repiten "esto no ha ocurrido" y vuelven a su cueva.

En primer lugar, lo que se hace aquí es mostrar que son una falacia los argumentos que nos han dado para convencernos de que los teoremas de la matemática son de naturaleza distinta a los de las demás ciencias por ser verdaderos independientemente de la experiencia. Para hacer esto se podría incluso suponer que el segundo teorema de Gödel no es experimental sin incurrir en contradicción. Para probar la negación de algo por reducción al absurdo se puede usar cualquier enunciado de ese algo. La carga de la prueba está en los que afirman que la matemática posee una naturaleza especial. No siendo válidos ninguno de estos argumentos, no hay ningún motivo para pensar que la matemática posee un status diferente a las demás ciencias en cuanto a su naturaleza. La diferencia es sólo de grado. Como ya he dicho, estas pruebas de que esos argumentos son falaces no son originales mías.

En segundo lugar, claro que la confianza que tenemos en el segundo teorema de Gödel es experimental. ¿Y qué problema hay con eso? Cuando Nidditch y Quine escriben "Un conocimiento de la teoría matemática que sea sólo probable es generalmente suficiente, y el único tipo de conocimiento de la consistencia que, de hecho, generalmente se tiene. [...] tal conocimiento probable encuentra un buen soporte en el hecho de que se haya trabajado tanto en las teorías de la matemática y no hayan salido a la luz teoremas contradictorios" y "las leyes lógicas son simplemente unos determinados enunciados del sistema donde no hay enunciado alguno inmune a la revisión" basan estas conclusiones en su experiencia (una de las más amplias y profundas del mundo) trabajando en la lógica matemática. ¿Acaso piensas que el pensamiento de estos expertos pierde validez por estar basado en conocimiento experimental? Si supones que el único conocimiento seguro es el de los enunciados analíticos, entonces es normal que concluyas que "hay enunciados analíticos". Pero eso no es un buen argumento racional. Es circular.

Entiendo que es duro darte cuenta de que lo que te han repetido miles de veces desde que eras pequeño no tiene base racional. Es, como dice Quine "un artículo metafísico de fe". Esperemos que los que no quieren debatir vayan madurando. Gracias de nuevo por la pregunta.

Buen artículo. Simplemente matizar que, además de las pruebas de consistencia relativa de la aritmética que mencionas (e ilustras con clarísimo símil), también existen pruebas de consistencia para modelos particulares de la axiomática (cf., e.g., Abian y LaMacchia "On the consistency and independence of some set-theoretical axioms" 1978), o pruebas de equiconsistencia (e.g., Gödel prueba en 1933, Zur intuitionistischen Arithmetik und Zahlentheorie, que la aritmética de Peano es consistente ssi lo es la de Heyting, siendo el intuicionismo un "testigo" argumentablemente más fiable; y aun luego demuestra, en Über eine bisher noch nicht benützte Erweiterung des finiten Standpunktes

ResponderEliminar1958, que ésta es consistente en el cálculo lamba simplemente tipado "sistema T" mediante su semántica dialéctica).

Lo digo no por menoscabar tu afirmación, con la que concuerdo, y sobre la que he escrito en varias ocasiones, sino para enfatizar que el origen de la no empiricidad de la matemática no es ese, si bien reconozco que es un buen punto de apoyo sobre el que hacer palanca, a modo de indicio.

Ah, y también están las axiomáticas que no cumplen el teorema de Gödel, y que puede demostrarse que son completas, como la aritmética de Presburger (1929), la geometría euclidea (Tarski "What is elementary geometry?" 1959), o la teoría de cuerpos cerrados de una característica dada (Tarski "A decision method for elementary algebra and geometry" 1948). (A este respecto, el programa de reverse mathematics siempre me ha parecido muy interesante)

ResponderEliminarDe hecho, esto me recuerda a una pequeña pega que le vi al artículo: tengo la sensación de que equiparas lógica y teoría de conjuntos a fundamentación, cuando eso fue así sólo en su génesis, y sólo por una parte de la comunidad. Por poner un ejemplo de sus aplicaciones en matemáticas avanzadas (no relacionadas con fundamentación), la demostración de que el ahora llamado "axioma de determinación proyectiva" es indemostrable en ZFC (y que llevaba torturando a geómetras décadas) viene precisamente de lógica y teoría de conjuntos.